Les commandes Hadoop que chaque Data Engineer doit connaître

Apprendre à naviguer et à exécuter des commandes dans le shell Hadoop est essentiel pour tout ingénieur de données.

Que vous deviez déplacer des données dans HDFS ou modifier le fichier de configuration du cluster, toutes ces tâches peuvent être effectuées à partir du shell Hadoop.

Préparez-vous à découvrir les commandes que chaque ingénieur de données doit connaître...

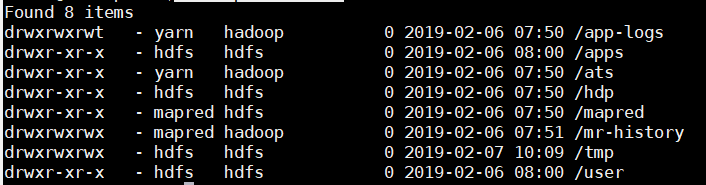

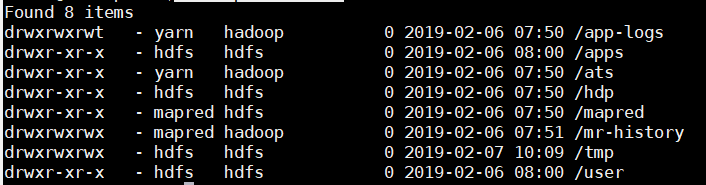

Répertorier les données actuelles dans le cluster Hadoop :

Deux cas :

Depuis le namenode :

Depuis une machine cliente :

hadoop fs -ls hdfs://namenodeHadoop:10001/

Créer un répertoire HDFS

hadoop fs -mkdir /sasdata

Depuis une machine cliente :

hadoop fs -ls hdfs://namenodeHadoop:10001/

Créer un répertoire HDFS

hadoop fs -mkdir /sasdata

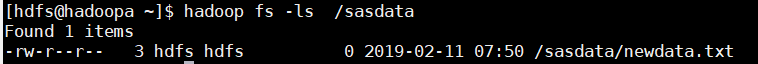

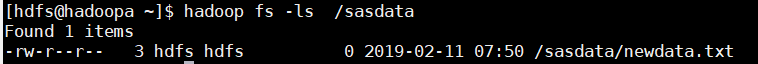

Créer un fichier

hadoop fs -touchz /sasdata/newdata.txt

Créer un fichier

hadoop fs -touchz /sasdata/newdata.txt

Supprimer un fichier sur HDFS

hadoop fs -rm /temp.txt

Supprimer un répertoire HDFS

hadoop fs -rmr /monRep

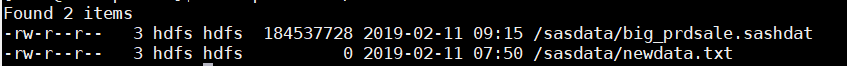

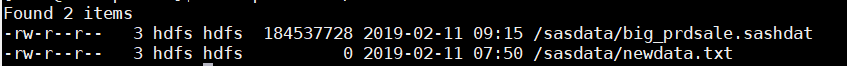

Copier des fichiers ou des dossiers du système local vers HDFS

hadoop fs -copyFromLocal /home/hdfs/sasdata/CASDATA/NFS/big_prdsale.sashdat /sasdata

Supprimer un fichier sur HDFS

hadoop fs -rm /temp.txt

Supprimer un répertoire HDFS

hadoop fs -rmr /monRep

Copier des fichiers ou des dossiers du système local vers HDFS

hadoop fs -copyFromLocal /home/hdfs/sasdata/CASDATA/NFS/big_prdsale.sashdat /sasdata

Définition de la réplication et de la taille du bloc lors de l'upload

La taille de bloc par défaut dans les datanodes hdfs est de 64 Mo. Mais vous pouvez augmenter à 128 ou 256mb selon vos besoins.

Le facteur de réplication est 3 par défaut, mais vous pouvez également l'augmenter.

Facteur de réplication :

hadoop fs -D dfs.replication=1 -put /home/hdfs/sasdata/CASDATA/customers.sashdat /tmp

hdfs dfs -stat %r /tmp/customers.sashdat

Ce qui donne 1

Block Size :

hadoop fs -D dfs.block.size=2939392 -cp file:/home/hdfs/sasdata/CASDATA/customers.sashdat /tmp/customers.sashdat

hadoop fs -stat "%F %u:%g %b %y %n - replication : %r - block size : %o" /tmp/customers.sashdat

Définition de la réplication et de la taille du bloc lors de l'upload

La taille de bloc par défaut dans les datanodes hdfs est de 64 Mo. Mais vous pouvez augmenter à 128 ou 256mb selon vos besoins.

Le facteur de réplication est 3 par défaut, mais vous pouvez également l'augmenter.

Facteur de réplication :

hadoop fs -D dfs.replication=1 -put /home/hdfs/sasdata/CASDATA/customers.sashdat /tmp

hdfs dfs -stat %r /tmp/customers.sashdat

Ce qui donne 1

Block Size :

hadoop fs -D dfs.block.size=2939392 -cp file:/home/hdfs/sasdata/CASDATA/customers.sashdat /tmp/customers.sashdat

hadoop fs -stat "%F %u:%g %b %y %n - replication : %r - block size : %o" /tmp/customers.sashdat

hadoop fs -ls /

Depuis une machine cliente :

hadoop fs -ls hdfs://namenodeHadoop:10001/

Créer un répertoire HDFS

hadoop fs -mkdir /sasdata

Depuis une machine cliente :

hadoop fs -ls hdfs://namenodeHadoop:10001/

Créer un répertoire HDFS

hadoop fs -mkdir /sasdata

Créer un fichier

hadoop fs -touchz /sasdata/newdata.txt

Créer un fichier

hadoop fs -touchz /sasdata/newdata.txt

Supprimer un fichier sur HDFS

hadoop fs -rm /temp.txt

Supprimer un répertoire HDFS

hadoop fs -rmr /monRep

Copier des fichiers ou des dossiers du système local vers HDFS

hadoop fs -copyFromLocal /home/hdfs/sasdata/CASDATA/NFS/big_prdsale.sashdat /sasdata

Supprimer un fichier sur HDFS

hadoop fs -rm /temp.txt

Supprimer un répertoire HDFS

hadoop fs -rmr /monRep

Copier des fichiers ou des dossiers du système local vers HDFS

hadoop fs -copyFromLocal /home/hdfs/sasdata/CASDATA/NFS/big_prdsale.sashdat /sasdata

Définition de la réplication et de la taille du bloc lors de l'upload

La taille de bloc par défaut dans les datanodes hdfs est de 64 Mo. Mais vous pouvez augmenter à 128 ou 256mb selon vos besoins.

Le facteur de réplication est 3 par défaut, mais vous pouvez également l'augmenter.

Facteur de réplication :

hadoop fs -D dfs.replication=1 -put /home/hdfs/sasdata/CASDATA/customers.sashdat /tmp

hdfs dfs -stat %r /tmp/customers.sashdat

Ce qui donne 1

Block Size :

hadoop fs -D dfs.block.size=2939392 -cp file:/home/hdfs/sasdata/CASDATA/customers.sashdat /tmp/customers.sashdat

hadoop fs -stat "%F %u:%g %b %y %n - replication : %r - block size : %o" /tmp/customers.sashdat

Définition de la réplication et de la taille du bloc lors de l'upload

La taille de bloc par défaut dans les datanodes hdfs est de 64 Mo. Mais vous pouvez augmenter à 128 ou 256mb selon vos besoins.

Le facteur de réplication est 3 par défaut, mais vous pouvez également l'augmenter.

Facteur de réplication :

hadoop fs -D dfs.replication=1 -put /home/hdfs/sasdata/CASDATA/customers.sashdat /tmp

hdfs dfs -stat %r /tmp/customers.sashdat

Ce qui donne 1

Block Size :

hadoop fs -D dfs.block.size=2939392 -cp file:/home/hdfs/sasdata/CASDATA/customers.sashdat /tmp/customers.sashdat

hadoop fs -stat "%F %u:%g %b %y %n - replication : %r - block size : %o" /tmp/customers.sashdat