Viya – SAS Data Connector to Hadoop et SAS Data Connect Accelerator for Hadoop

Avant de commencer, il faut distinguer SAS Data Connector to Hadoop et SAS Data Connect Accelerator for Hadoop :

A propos du mode de transfert

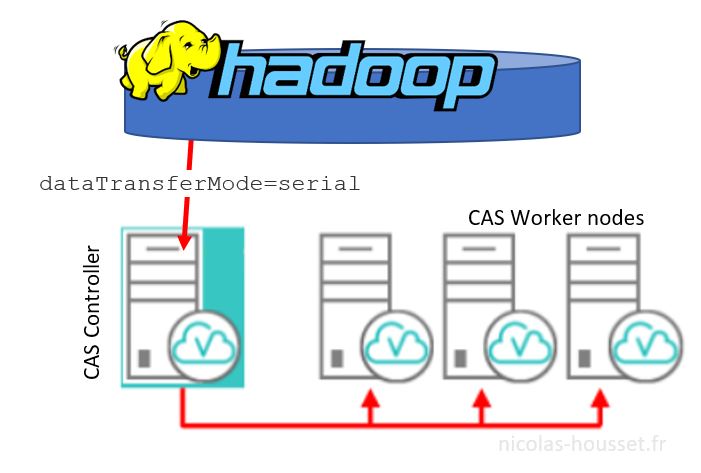

Dans l'exemple ci-dessus, je n'ai pas précisé le mode de transfert des données de Hive vers CAS ( option dataTransferMode).

Par défaut, le mode est définit à SERIAL, c'est à dire que le chargement des données se fait via SAS Data Connector to Hadoop.

Vous pouvez définir l'option dataTransferMode à PARALLEL (et ainsi utiliser les SAS Embedded Process)

A propos du MultiNode Data Transfer

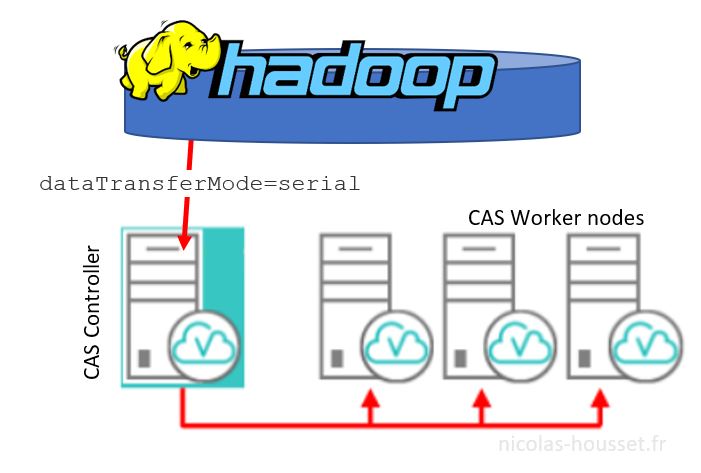

A partir de SAS Viya 3.3, un nouveau mécanisme de transfert de données «MultiNode Data Transfer» a été mis en place pour transférer des données entre la source de données et CAS), en plus des modes de transfert de données SERIAL et PARALLEL .

Ce mécanisme est une extension du mode Serial Data Transfer. En mode de transfert de données multi-nœuds, chaque agent CAS effectue une connexion simultanée pour lire et écrire des données dans Hadoop.

Aussi, l'option NUMREADNODES (et NUMWRITENODES) permet de spécifier le nombre de node CAS à utiliser pour le chargement. Définir cette option sur une valeur autre que 1 (valeur par défaut) permet à SAS Data Connector to Hadoop d'utiliser plusieurs nœuds pour charger des données dans CAS.

Vous pouvez spécifier n'importe quelle valeur jusqu'au nombre total de nodes disponibles.

Vous pouvez spécifier la valeur 0 pour utiliser tous les nodes disponibles. Si NUMREADNODES ou NUMWRITENODES est une valeur autre que 1 et DATATRANSFERMODE = "AUTO", SAS tente d'abord de transférer les données en parallèle à l'aide de SAS Data Connect Accelerator.

Si le transfert parallèle échoue, SAS tente de transférer des données avec le connecteur de données en utilisant le nombre spécifié de nodes CAS. Si plusieurs nodes ne sont pas disponibles, SAS transfère les données en série.

Notes

Comme indiqué au début de cet article, le chargement de données en parallèle à l'aide de SAS Embedded Process nécessite une licence distincte pour SAS Data Connect Accelerator for Hadoop et une plateforme Viya MPP.

A noter également que, JAVA_HOME doit pointer vers l'emplacement du JRE Java 8 installé et LIBJVM.SO doit être spécifié dans LD_LIBRARY_PATH. Précisez ces paramètres dans la configuration CAS :

Vous pouvez définir l'option dataTransferMode à PARALLEL (et ainsi utiliser les SAS Embedded Process)

A propos du MultiNode Data Transfer

A partir de SAS Viya 3.3, un nouveau mécanisme de transfert de données «MultiNode Data Transfer» a été mis en place pour transférer des données entre la source de données et CAS), en plus des modes de transfert de données SERIAL et PARALLEL .

Ce mécanisme est une extension du mode Serial Data Transfer. En mode de transfert de données multi-nœuds, chaque agent CAS effectue une connexion simultanée pour lire et écrire des données dans Hadoop.

Aussi, l'option NUMREADNODES (et NUMWRITENODES) permet de spécifier le nombre de node CAS à utiliser pour le chargement. Définir cette option sur une valeur autre que 1 (valeur par défaut) permet à SAS Data Connector to Hadoop d'utiliser plusieurs nœuds pour charger des données dans CAS.

Vous pouvez spécifier n'importe quelle valeur jusqu'au nombre total de nodes disponibles.

Vous pouvez spécifier la valeur 0 pour utiliser tous les nodes disponibles. Si NUMREADNODES ou NUMWRITENODES est une valeur autre que 1 et DATATRANSFERMODE = "AUTO", SAS tente d'abord de transférer les données en parallèle à l'aide de SAS Data Connect Accelerator.

Si le transfert parallèle échoue, SAS tente de transférer des données avec le connecteur de données en utilisant le nombre spécifié de nodes CAS. Si plusieurs nodes ne sont pas disponibles, SAS transfère les données en série.

Notes

Comme indiqué au début de cet article, le chargement de données en parallèle à l'aide de SAS Embedded Process nécessite une licence distincte pour SAS Data Connect Accelerator for Hadoop et une plateforme Viya MPP.

A noter également que, JAVA_HOME doit pointer vers l'emplacement du JRE Java 8 installé et LIBJVM.SO doit être spécifié dans LD_LIBRARY_PATH. Précisez ces paramètres dans la configuration CAS :

- SAS Data Connector to Hadoop vous permet de charger des données en série depuis Hive dans SAS Cloud Analytic Services ( CAS ) Tous les utilisateurs peuvent utiliser SAS Data Connector to Hadoop.

- SAS Data Connect Accelerator for Hadoop est un produit supplémentaire qui vous permet de charger des données en parallèle à l'aide des SAS Embedded Process (SAS Ep)

Création de la caslib hive :

|

1 2 3 4 5 |

caslib myCashive desc="HIVE Caslib Serial" datasource=(SRCTYPE="hadoop",server="monserveurhive" HADOOPCONFIGDIR="/opt/sas/viya/config/data/hadoop/conf", HADOOPJARPATH="/opt/sas/viya/config/data/hadoop/lib", schema="default",dfDebug=sqlinfo); |

Vous pouvez définir l'option dataTransferMode à PARALLEL (et ainsi utiliser les SAS Embedded Process)

A propos du MultiNode Data Transfer

A partir de SAS Viya 3.3, un nouveau mécanisme de transfert de données «MultiNode Data Transfer» a été mis en place pour transférer des données entre la source de données et CAS), en plus des modes de transfert de données SERIAL et PARALLEL .

Ce mécanisme est une extension du mode Serial Data Transfer. En mode de transfert de données multi-nœuds, chaque agent CAS effectue une connexion simultanée pour lire et écrire des données dans Hadoop.

Aussi, l'option NUMREADNODES (et NUMWRITENODES) permet de spécifier le nombre de node CAS à utiliser pour le chargement. Définir cette option sur une valeur autre que 1 (valeur par défaut) permet à SAS Data Connector to Hadoop d'utiliser plusieurs nœuds pour charger des données dans CAS.

Vous pouvez spécifier n'importe quelle valeur jusqu'au nombre total de nodes disponibles.

Vous pouvez spécifier la valeur 0 pour utiliser tous les nodes disponibles. Si NUMREADNODES ou NUMWRITENODES est une valeur autre que 1 et DATATRANSFERMODE = "AUTO", SAS tente d'abord de transférer les données en parallèle à l'aide de SAS Data Connect Accelerator.

Si le transfert parallèle échoue, SAS tente de transférer des données avec le connecteur de données en utilisant le nombre spécifié de nodes CAS. Si plusieurs nodes ne sont pas disponibles, SAS transfère les données en série.

Notes

Comme indiqué au début de cet article, le chargement de données en parallèle à l'aide de SAS Embedded Process nécessite une licence distincte pour SAS Data Connect Accelerator for Hadoop et une plateforme Viya MPP.

A noter également que, JAVA_HOME doit pointer vers l'emplacement du JRE Java 8 installé et LIBJVM.SO doit être spécifié dans LD_LIBRARY_PATH. Précisez ces paramètres dans la configuration CAS :

Vous pouvez définir l'option dataTransferMode à PARALLEL (et ainsi utiliser les SAS Embedded Process)

A propos du MultiNode Data Transfer

A partir de SAS Viya 3.3, un nouveau mécanisme de transfert de données «MultiNode Data Transfer» a été mis en place pour transférer des données entre la source de données et CAS), en plus des modes de transfert de données SERIAL et PARALLEL .

Ce mécanisme est une extension du mode Serial Data Transfer. En mode de transfert de données multi-nœuds, chaque agent CAS effectue une connexion simultanée pour lire et écrire des données dans Hadoop.

Aussi, l'option NUMREADNODES (et NUMWRITENODES) permet de spécifier le nombre de node CAS à utiliser pour le chargement. Définir cette option sur une valeur autre que 1 (valeur par défaut) permet à SAS Data Connector to Hadoop d'utiliser plusieurs nœuds pour charger des données dans CAS.

Vous pouvez spécifier n'importe quelle valeur jusqu'au nombre total de nodes disponibles.

Vous pouvez spécifier la valeur 0 pour utiliser tous les nodes disponibles. Si NUMREADNODES ou NUMWRITENODES est une valeur autre que 1 et DATATRANSFERMODE = "AUTO", SAS tente d'abord de transférer les données en parallèle à l'aide de SAS Data Connect Accelerator.

Si le transfert parallèle échoue, SAS tente de transférer des données avec le connecteur de données en utilisant le nombre spécifié de nodes CAS. Si plusieurs nodes ne sont pas disponibles, SAS transfère les données en série.

Notes

Comme indiqué au début de cet article, le chargement de données en parallèle à l'aide de SAS Embedded Process nécessite une licence distincte pour SAS Data Connect Accelerator for Hadoop et une plateforme Viya MPP.

A noter également que, JAVA_HOME doit pointer vers l'emplacement du JRE Java 8 installé et LIBJVM.SO doit être spécifié dans LD_LIBRARY_PATH. Précisez ces paramètres dans la configuration CAS :

|

1 2 |

export JAVA_HOME=/usr/java/latest/jre export LD_LIBRARY_PATH=$JAVA_HOME/lib/amd64/server:$LD_LIBRARY_PATH |